国外speaking实践过程拍击:惊现笑料不断,传播跨文化交流真谛

60074 2023-12-23 08:50

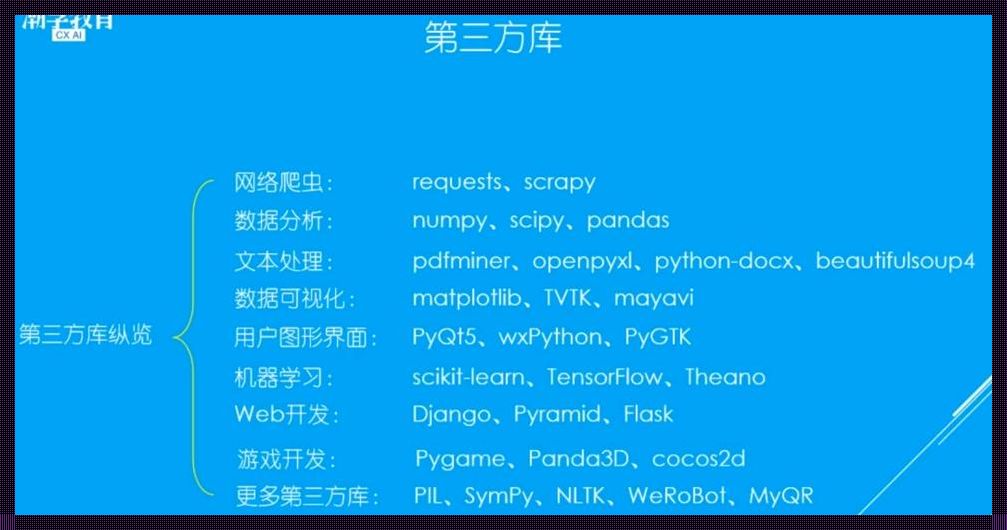

在这个信息爆炸的时代,文本数据无处不在,无时不在。对于我们数据科学家来说,掌握文本处理技术,就等于拥有了打开数据宝库的钥匙。而在Python这个强大的数据分析工具中,文本处理第三方库就是那把钥匙的把手,让我们能更轻松地转动钥匙,开启宝库的大门。

首先,让我们来谈谈NLTK,这个被誉为自然语言处理领域的“瑞士军刀”的库。它拥有强大的分词、词性标注、命名实体识别等功能,就像一个全能的助手,帮助我们处理文本数据中的各种问题。而它的使用方法也非常简单,只需几行代码,就能实现强大的文本处理功能。

再来是spaCy,这个近年来崛起的文本处理库。它的速度比NLTK快,准确率也更高,特别适合处理大规模的文本数据。而且,spaCy的API设计非常人性化,让我们在处理文本数据时,有一种行云流水的感觉。

当然,还有gensim这个主题模型库,它可以帮助我们挖掘文本数据中的潜在主题,就像一个侦探,帮助我们找出文本中的隐藏信息。而gensim的使用也非常简单,只需几行代码,就能生成文本的主题模型。

以上这些库,都是我们在处理文本数据时的得力助手。它们各自有着独特的优点,但也有着一些共同的特性。比如,它们都支持Python这个强大的数据分析工具,都拥有丰富的功能和强大的处理能力,都提供了简单易用的API,让我们在处理文本数据时,能够事半功倍。

总的来说,Python文本处理第三方库,就像是一个强大的工具箱,里面有着各种各样的工具,可以帮助我们解决文本处理中的各种问题。而我们要做的,就是学会如何使用这些工具,让它们为我们服务,帮助我们更好地理解和利用文本数据。