国外speaking实践过程拍击:惊现笑料不断,传播跨文化交流真谛

61579 2023-12-23 08:50

在云计算和大数据时代,Hadoop分布式文件系统(HDFS)作为处理海量数据的基石,其重要性不言而喻。对于Hadoop集群管理员而言,能够快速便捷地启动HDFS服务是日常运维工作的关键需求。本文将揭秘这一过程中常用的一键启动脚本。

HDFS(Hadoop Distributed File System)是Hadoop分布式计算框架中的一部分,它提供了一个分布式文件存储系统,用以存储大数据应用程序的文件。HDFS集群由NameNode、DataNode等多种角色组成,各角色协同工作,保障了文件系统的高吞吐量和容错性。

要在集群中启动HDFS服务,通常会使用脚本来一键化地执行这一过程。这个脚本会包含一系列的命令,用于初始化配置、启动各个节点上的服务,并确保所有的节点都同步状态。一键启动脚本的便捷之处在于,它可以减少重复性工作,提高工作效率,特别是在大型集群中,可以节省大量的时间和劳动力。

一键启动脚本通常会涉及以下几个步骤:

环境检查:脚本首先会检查Hadoop的运行环境,包括Java虚拟机是否安装,Hadoop配置文件是否齐全等。

配置文件同步:HDFS集群需要所有节点的配置文件保持一致,脚本会确保这一点。

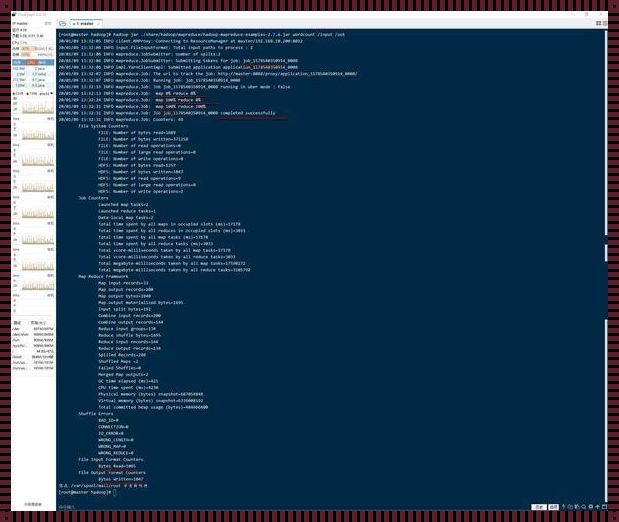

服务启动:脚本会依次启动NameNode、DataNode等服务。

状态检查:在启动过程中,脚本会不断检查服务状态,确保每个节点都正常工作。

健康检查:启动完成后,脚本通常还会执行健康检查,验证HDFS是否完全准备好接收和处理数据。

使用一键启动脚本,管理员可以坐观其成,专注于其他关键任务,而不必逐一登录到每个节点上手动启动服务。这种脚本的编写和维护,需要深入理解Hadoop的工作原理和命令行操作,同时也要求高度的耐心和细心,以确保脚本的稳定性和可靠性。

掌握这个脚本的编写和使用,对于Hadoop集群管理员来说,是提升工作效率,确保数据处理不受干扰的关键技能。通过对一键启动脚本的深入揭秘,我们不仅理解了HDFS集群启动的流程,也体会到了自动化运维工具在现代数据中心中的重要性。